L’AI sicura, trasparente ed etica è un’opportunità per le imprese

Non solo divieti: l’AI Act apre nuovi spazi di mercato alle imprese che capiscono il trend. L’analisi di Andrea Rossetti (Bicocca), giurista esperto in innovazione e sicurezza digitale.

Il nuovo regolamento sull’intelligenza artificiale (2021/206), votato a larga maggioranza dal Parlamento Europeo (più di cinquecento i voti favorevoli) e pronto per la ratifica dei paesi membri, tutelerà i consumatori da una vasta serie di rischi connessi all’implementazione e all’utilizzo di AI su tutto il territorio dell’Unione Europea. Lo fa istituendo una scala della pericolosità dell’AI (da “minima” a “inaccettabile”) e fissando regole stringenti per chi è titolare della produzione o della fornitura dei sistemi che ne sono all’origine. Maggiori sono i rischi, maggiori saranno gli obblighi, i limiti ed eventualmente le multe a carico dei soggetti coinvolti, cioè aziende che per la prima volta si trovano nel mirino di una disciplina di questa portata.

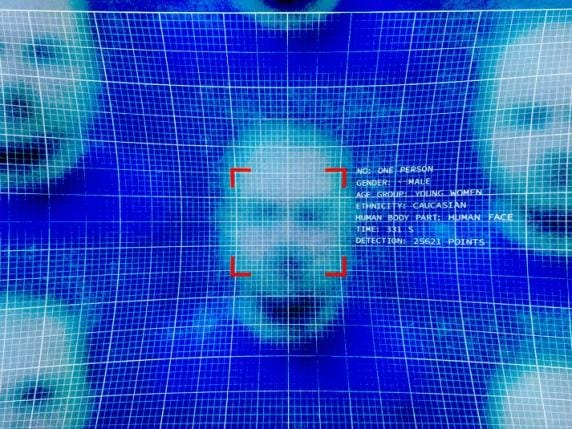

Facciamo qualche esempio. Il rischio è considerato “inaccettabile” quando l’AI viola i valori fondamentali dell’Unione Europea: è il caso degli strumenti di polizia predittiva, che assemblano i dati per valutare la pericolosità di un individuo (già in uso negli States), e dei sistemi che analizzano gli utenti per sfruttare caratteristiche vulnerabili come l’età (anziani e minori), una disabilità, o comunque una specifica situazione di difficoltà sociale, economica o psicologica. In questi casi le attività sono da considerare proibite su tutto il territorio. Banditi dalle scuole e dai luoghi di lavoro i sistemi di riconoscimento delle emozioni, cioè quelli che interpretano il tono della voce, i gesti e le espressioni facciali dell’utente per capirne l’umore (e agire di conseguenza), qualunque sia lo scopo della rilevazione, qualunque sia il servizio che s’intende proporre o l’effetto che si vuole suscitare. Riconoscimento facciale concesso solo alle forze dell’ordine e sottoposto a condizioni rigorose.

‟Un retailer che offre raccomandazioni altamente personalizzate ai suoi utenti dovrà tenere presente che l’AI Act lo classifica come un uso ad alto rischio”

Secondo Andrea Rossetti, professore associato di Filosofia del diritto in Bicocca, che è anche tra i promotori del nuovo corso di laurea “AI and human decision-making”, «è probabile che i livelli di sicurezza e trasparenza dell’AI crescano, limitandone alcuni usi ma anche stimolando l’innovazione in direzioni più etiche e responsabili. Ad esempio, un retailer che voglia offrire raccomandazioni altamente personalizzate ai suoi utenti dovrà tenere presente che l’AI Act classifica quest’uso come ad “alto rischio” per la privacy e la protezione dei dati personali. Pertanto, dovrà garantire che il suo sistema di raccomandazione sia completamente trasparente riguardo ai dati che raccoglie e all’uso che ne fa. Inoltre, dovrà offrire agli utenti in modo semplice la possibilità di rinunciare a questo uso (probabilmente attraverso un sistema di opt-in come previsto dal codice del consumo). In ogni caso, l’algoritmo dovrà evitare discriminazioni assicurando che le raccomandazioni siano eque e non influenzate da sesso, etnia, convinzioni religiose o background socioeconomico».

Dall’AI Act arriva anche una definizione ufficiale di “intelligenza artificiale”, necessaria a individuare tutte le espressioni tecnologiche che ricadono sotto la sua disciplina. Si tratta di tutti i “sistemi basati su macchine e progettati per operare con vari livelli di autonomia, che possono mostrare capacità di adattamento […] e che, per obiettivi espliciti o impliciti, deducono dagli input come generare i propri output”. Gli output possono essere “previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali”. Si tratta dunque di una definizione estremamente ampia, volta a ricomprendere qualunque applicazione presente o futura di AI, per le più diverse finalità. Anche quelle non dichiarate.

‟L’AI Act potrebbe scoraggiare alcuni investimenti sulle imprese europee, ma fa spazio per la creazione di un nuovo vantaggio competitivo”

Per firmatari e sostenitori si tratta di una giornata storica, una vittoria della politica sullo sviluppo incontrollato del mercato, ma comunque non si configura come un attacco alle lobby della tecnologia, che hanno contribuito in vario modo all’iter di questo testo e ottenuto compromessi a tutela dei loro interessi di categoria. Ad esempio la francese Mistral, fondata nell’aprile 2023 da ex dipendenti di Meta Platforms e Google DeepMind, è entrata in partnership con Microsoft non appena l’AI Act ha superato il vaglio del Parlamento: questo ci dice che il tessuto produttivo europeo non è ancora autonomo nello sviluppo di modelli linguistici che possano competere sul mercato globale, ma significa anche che il nuovo regolamento non sbarra le porte agli investimenti extra-UE.

«Da qualcuno potrà essere percepito come un ostacolo all’innovazione e alla rapidità di sviluppo dei prodotti: soprattutto nel confronto con regioni meno regolamentate – avverte Andrea Rossetti – l’AI Act potrebbe scoraggiare alcuni investimenti sulle imprese europee. Tuttavia è importante considerare anche gli aspetti positivi che una regolamentazione ben concepita può portare nel medio periodo, in termini di promozione dell’innovazione responsabile e di creazione di un vantaggio competitivo basato sulla fiducia e sulla sostenibilità. In questo senso fa scuola la risposta di Apple all’introduzione del GDPR: con un importante investimento sulle tecnologie di protezione dei dati, dopo il 2016 ha sviluppato un nuovo prodotto con altissimi livelli di compliance, quindi competitivo in un mercato in cui la tutela della privacy è non solo un obbligo, ma anche un valore in ascesa per il consumatore. Questo approccio ha premiato Apple con un forte ritorno di immagine e conseguenti risultati nelle vendite».

Fonte: altaviawatch.com